-

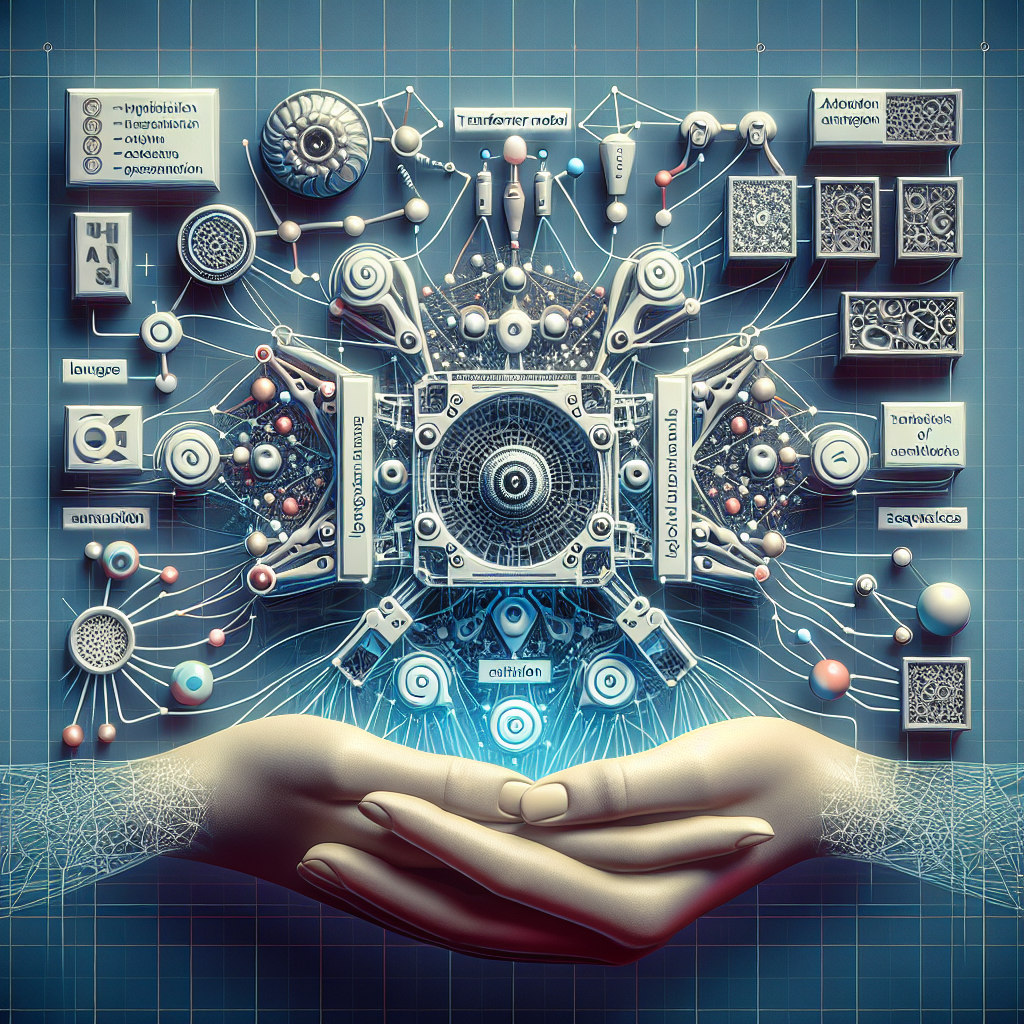

Você sabia que as redes neurais tradicionais têm um limite quando o assunto é sequência e tradução? 🚫 Descubra como a nova arquitetura Transformer, que dispensa completamente a recorrência, promete revolucionar a forma como entendemos e implementamos modelos de linguagem. Prepare-se para entender como a atenção pode ser a chave para esse avanço!

-

Quantas vezes você já sentiu que um modelo de linguagem poderia explorar mais? 🤔 A verdade é que as redes neurais recorrentes estão se tornando coisa do passado. Conheça o Transformer, um modelo que promete romper barreiras e elevar a qualidade das traduções a um novo patamar. Será que a atenção é realmente suficiente para isso?

-

O segredo por trás das traduções de alta qualidade pode estar em algo simples: atenção. 👀 Mas será que isso é suficiente para soluções verdadeiramente inovadoras? Venha entender como o modelo Transformer, que ignora a recorrência, está mudando o jogo e o que isso significa para o futuro da inteligência artificial!

-

Simplicidade do Transformer: O Transformer é uma arquitetura inovadora que utiliza apenas mecanismos de atenção, eliminando a necessidade de redes neurais recorrentes ou convolucionais. Isso simplifica o processo de modelagem de sequência, permitindo que o modelo foque em relações globais em vez de dependências sequenciais.

-

Treinamento mais Rápido: Graças à sua estrutura, o Transformer pode ser treinado em menos tempo. Em testes, ele conseguiu alcançar resultados superiores em tarefas de tradução após somente 12 horas de treinamento em oito GPUs, muito mais rápido do que arquiteturas tradicionais.

-

Resultados em Tradução: No WMT 2014, o Transformer obteve uma pontuação BLEU de 28.4 na tradução inglês-alemão e 41.8 na inglês-francês. Isso não só superou os melhores resultados anteriores como também ao custo de treinamento significativamente menor.

-

Aplicabilidade Ampla: Além de tradução, o Transformer mostrou bom desempenho em outras tarefas, como análise sintática em inglês, demonstrando sua versatilidade em diferentes contextos de modelagem de sequência.

Esses pontos destacam como o modelo Transformer traz inovações que permitem não apenas melhorar a eficiência em tarefas de tradução, mas também ampliar seu uso em vários domínios de inteligência artificial!

A revolução no processamento de linguagem natural chegou com o Transformer, um modelo que transforma a maneira como interagimos com dados sequenciais. E você, como acredita que a tecnologia de atenção pode impactar sua área de atuação? Compartilhe suas experiências ou dúvidas nos comentários! Vamos continuar essa conversa!

#Transformer #ProcessamentoDeLinguagem #InteligênciaArtificial #MachineLearning #TecnologiaInovadora